"Efficacia nell'uso dell'energia" (PUE) come unità di misura

La domanda globale di elettricità è di circa 20.000 terawattora; il settore ICT (Information and Communications Technology) utilizza 2.000 terawattora, mentre i data center circa 200 terawattora, pari all'1% del totale. I data center rappresentano quindi una parte significativa del consumo energetico della maggior parte dei paesi. È stato stimato che ci siano oltre 18 milioni di server nei data center a livello globale. Oltre ai propri requisiti di alimentazione, questi dispositivi IT richiedono anche infrastrutture di supporto come sistemi di raffreddamento, distribuzione dell'alimentazione, spegnimento di incendi, gruppi di continuità, generatori, ecc.

Per confrontare l'efficienza energetica nei data center, è prassi comune utilizzare come unità di misura l'efficacia nell'uso dell'energia (PUE). Questo è definito come il rapporto tra l'energia totale utilizzata in un data center e l'energia utilizzata solo dall'IT. In uno scenario ottimale, la PUE sarebbe 1, ossia tutta l'energia sarebbe consumata per l'IT e l'infrastruttura di supporto non consumerebbe energia.

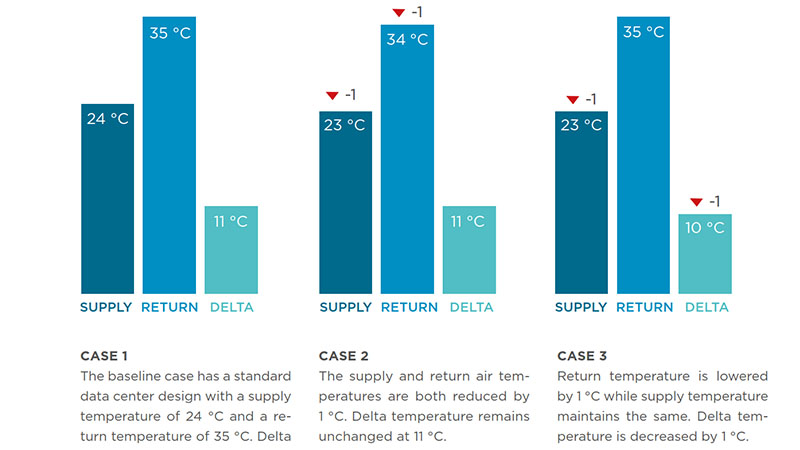

Pertanto, per ridurre al minimo il valore di PUE, l'obiettivo è ridurre il consumo delle infrastrutture di supporto, come il raffreddamento e la distribuzione dell'alimentazione. Il valore PUE tipico nei data center tradizionali è di circa 2, mentre i grandi data center di hyperscale possono scendere al di sotto di 1,2. Nel 2020, la media globale era di circa 1,67, pertanto, in media, il 40% del consumo totale di energia è consumo non IT. Tuttavia, il valore di PUE è un rapporto, quindi non è indicativo del consumo energetico complessivo; pertanto, se i dispositivi IT consumano un livello elevato di energia rispetto al sistema di raffreddamento, il valore PUE avrà un buon valore. È quindi importante misurare anche il consumo energetico totale, nonché l'efficienza e il ciclo di vita delle apparecchiature IT. Inoltre, dal punto di vista ambientale, si dovrebbero prendere in considerazione il modo in cui viene prodotta l'elettricità, la quantità di acqua consumata (sia per generare l'elettricità sia nel sito per il raffreddamento) e l'eventuale utilizzo del calore di scarto.

Il concetto di PUE è stato originariamente sviluppato da Green Grid nel 2006 e pubblicato come standard ISO nel 2016. Green Grid è un consorzio industriale aperto di operatori di data center, fornitori di servizi cloud, fornitori di tecnologia e apparecchiature, architetti di strutture e utenti finali, lavorando a livello globale nell'efficienza energetica e delle risorse degli ecosistemi dei data center, cercando di ridurre al minimo le emissioni di carbonio.

Il valore di PUE rimane il metodo più comune per calcolare l'efficienza energetica dei data center. In Munters, ad esempio, la PUE viene valutata sia su base massima che su base annua per ciascun progetto. Quando si calcolano le metriche PUE, nel calcolo della PUE vengono presi in considerazione solo il carico IT e il carico di raffreddamento. Questo è indicato come PUE parziale (pPUE) o PUE meccanico (PUEM). Il picco pPUE viene utilizzato dagli ingegneri elettrici per stabilire i carichi massimi e per dimensionare i generatori di riserva. Il pPUE annualizzato viene utilizzato per valutare e confrontare con altre opzioni di raffreddamento la quantità di elettricità consumata durante un anno tipico. Anche se il valore di PUE può non essere uno strumento perfetto, è sempre più supportato da altre unità di misura come WUE (efficacia dell'utilizzo dell'acqua), CUE (efficacia dell'utilizzo del carbonio), nonché approcci che possono migliorare la rilevanza della PUE, tra cui SPUE (server PUE ) e TUE (PUE totale).